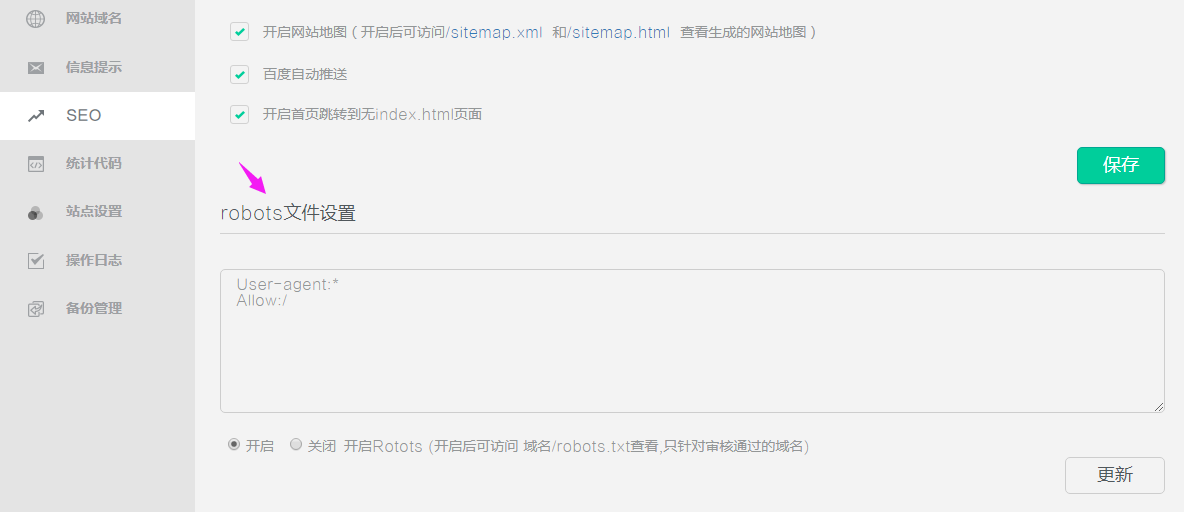

网站的Robots如何设置?

2021-06-22

Robots是网站和爬虫之间的沟通方式,它用来指导搜索引擎更好地抓取网站内容,更好的保护用户的隐私。

robots默认为关闭状态。它在开启后,如未作内容的设置,则对于所有的搜索引擎蜘蛛,该网站都是开放的可以被抓取的。

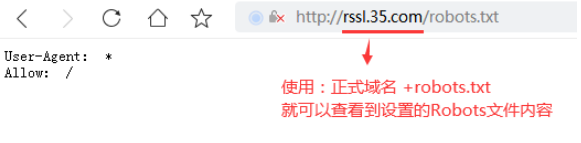

开启后前台访问显示:

Robots内容的设置是有规则的,有此类内容设置需求的用户,建议先百度了解、学习规则后再设置内容。

https://baike.baidu.com/item/robots%E5%8D%8F%E8%AE%AE/2483797

举例,如下:

" User-agent:* “这样的记录只能有一条, * 号表示该协议对任何搜索引擎蜘蛛均有效”。

“ Disallow:用于描述不希望被访问到的一个URL,这个URL可以是一条完整的路径,也可以是部分的,任何以Disallow开头的URL均不会被Robot访问到。

021-63305889

021-63305889